10 JUIN 2025

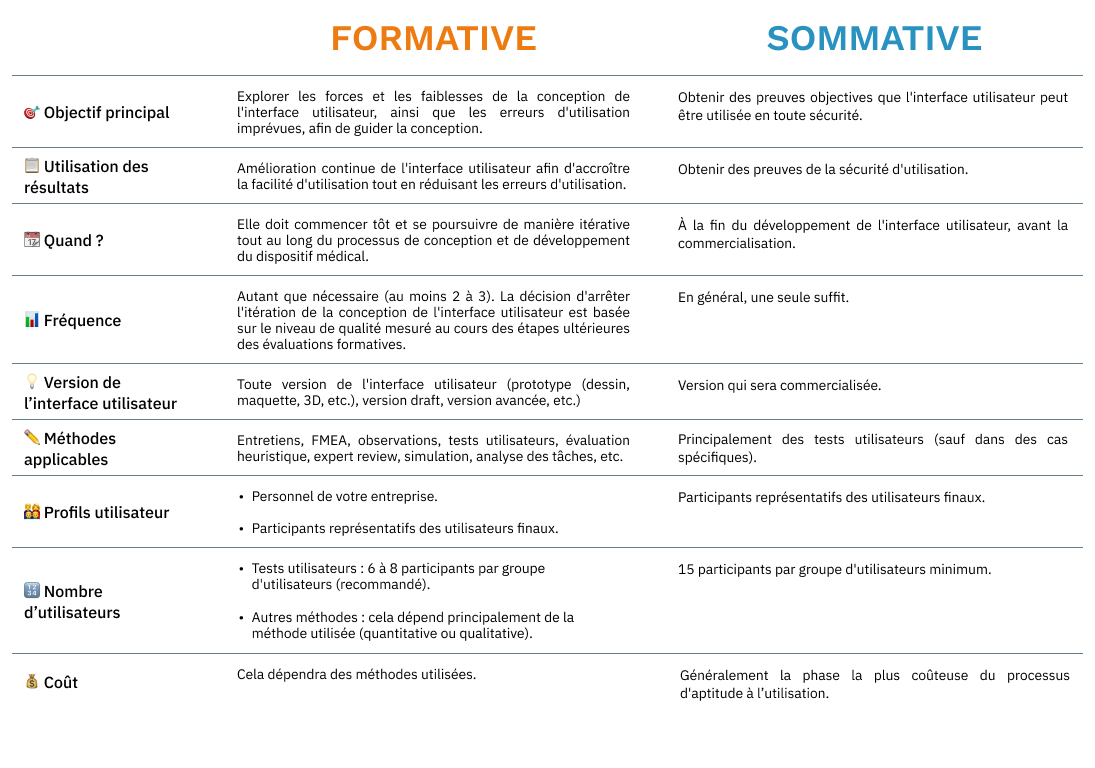

Évaluation formative vs sommative : quelles différences ?

Aptitude à l'utilisation

L’objectif du processus d’aptitude à l’utilisation est de comprendre comment les utilisateurs interagissent avec un dispositif médical, d’étudier l’impact de la conception des interfaces sur ces interactions, et de créer une interface intuitive permettant aux utilisateurs de l’utiliser en tout sécurité. Deux évaluations clés sont mentionnées dans ce processus : l’évaluation formatives et l’évaluation sommative.

L'évaluation formative

Il s’agit d’une évaluation de l’interface utilisateur dont le but est d’identifier les forces et les faiblesses de la conception, d’identifier les erreurs d’utilisation non anticipées, d’itérer progressivement et d’améliorer l’interface avant sa version finale.

Quand la réaliser ?

Le plus tôt possible et tout au long du processus de développement. Les évaluations formatives doivent être menées à chaque étape clé de la conception. Elles permettent également compléter les étapes réalisées en amont (par exemple, l’analyse des risques d’usage).

Combien en réaliser ?

La norme EN 62366 recommande de réaliser deux à trois évaluations formatives, voire plus en fonction de la complexité de l’interface. En réalité, il n’existe pas de nombre magique et la décision d’arrêter se base sur le niveau de confiance du fabricant concernant son interface. Lorsque la conception est considérée comme suffisamment aboutie, une dernière évaluation formative, souvent sous forme de tests utilisateurs, peut être réalisée pour préparer l’évaluation sommative.

Sur quels éléments de l’interface utilisateur ?

Tous les éléments de l’interface peuvent faire l’objet d’évaluations : dispositif physique ou numérique, documentation, formation, packaging, étiquetage… quelle que soit leur niveau d’avancement (croquis, idées, prototypes, maquettes interactives, versions finalisées…).

Il est vivement recommandé de les initier le plus tôt possible : il est préférable d’identifier rapidement ce qui fonctionne ou non pour orienter la conception dans la bonne direction, plutôt que de le découvrir une fois le produit finalisé et les modifications coûteuses.

Quelles méthodes utiliser ?

L’annexe E de l’IEC TR 62366-2 : 2016 recense 19 méthodes d’évaluation formative pouvant être utilisées tout au long du processus de développement.

Avant de choisir une méthode, il est essentiel de définir l’objectif de l’évaluation : s’agit-il de mettre à jour l’analyse des risques, de guider la conception de l’interface ou d’évaluer une version existante ?

En fonction de cela, certaines approches seront plus pertinentes : par exemple, une FMEA pour identifier des risques d’usage, un focus group pour explorer des idées de conception, ou un test utilisateur pour évaluer l’efficacité et la sécurité d’une interface.

Une même méthode peut parfois répondre à plusieurs objectifs, même si l’un d’eux reste généralement prédominant. Par exemple, un test utilisateur peut simultanément révéler de nouveaux risques, suggérer des pistes d’amélioration et mettre en évidence des défauts de conception.

Avec quels utilisateurs ?

Le choix des participants à l’évaluation formative a un impact direct sur la qualité des retours obtenus. Plusieurs profils peuvent être mobilisés, chacun avec ses avantages et ses limites. Impliquer du personnel interne à l’entreprise peut sembler pratique : ces personnes sont faciles à recruter, disponibles, et leur mobilisation est peu coûteuse. Ce type de profil peut s’avérer pertinent pour des produits destinés au grand public. Toutefois, si ces participants ne sont pas représentatifs des utilisateurs finaux, les résultats risquent d’être biaisés. Par exemple, un comptable n’aura pas les mêmes connaissances ni les mêmes attentes qu’un infirmier lorsqu’il s’agit de manipuler une seringue. À l’inverse, faire appel à des utilisateurs représentatifs est essentiel pour identifier les véritables points de friction. Leur expérience permet d’obtenir des retours plus riches et plus proches de la réalité d’usage. Il est toutefois important de garder à l’esprit qu’un utilisateur ayant participé à l’évaluation formative ne pourra pas être inclus dans l’évaluation sommative car sa familiarité avec l’interface constituerait un biais pour les résultats. Dans les deux cas, il est recommandé de varier les profils des participants au sein de chaque session afin d’éviter de concevoir un produit qui ne serait adapté qu’à un type d’utilisateur.

Combien d’utilisateurs ?

Selon la méthode, l’IEC TR 62366-2 recommande :

- Tests utilisateurs : 5 à 8 par groupe utilisateur

- Advisory panels : 5 à 10

- Focus groups : 4 à 8

- Analyses heuristiques : 1 à 3 experts

- Entretiens individuels : 20+ pour un échantillon hétérogène, 6 à 8 pour un groupe homogène (âge, métier, handicap…)

Pour les autres méthodes, il n’y a pas de nombre fixé. Cela dépend de la nature, qualitative ou quantitative, de l’étude.

Comment la documenter ?

1. Rédiger un protocole : méthode utilisée, objectifs, profils des participants…

2. Rédiger un rapport, même concis : forces, faiblesses, nouveaux risques identifiés.

3. Documenter les modifications : quels retours ont été pris en compte et pourquoi.

Attention, tous les retours ne sont pas à appliquer systématiquement. Les évaluations aident à ajuster progressivement l’interface, en fonction des priorités, de la roadmap et de l’impact de la modification :

- Certaines recommandations ne sont pas applicables (coûts, contraintes techniques…) ;

- Certaines recommandations ne sont pas prioritaires face à des recommandations qui auront un impact immédiat sur l’expérience utilisateur et la sécurité ;

- Certains retours ne sont pas pertinents (préférence personnelle, biais, cas spécifique…).

L’évaluation sommative

C’est l’évaluation finale de l’interface utilisateur, réalisée à la fin du développement. Elle a pour objectif de fournir une preuve tangible que les mesures mises en place permettent de réduire les risques d’usage et que le dispositif peut être utilisé de manière sûre par les utilisateurs finaux dans l’environnement d’utilisation prévue. C’est une étape obligatoire pour le marquage CE.

Quand la réaliser ?

À la fin du développement, juste avant la commercialisation ou les essais cliniques.

Combien d’évaluations ?

En principe, une seule évaluation sommative suffit. Toutefois, en fonction de la complexité de l’interface et du nombre de tâches à réaliser, il peut être nécessaire d’en prévoir plusieurs.

En effet, si la durée totale du test dépasse deux heures par participant, cela risque d’entraîner une fatigue cognitive, une baisse de concentration et, par conséquent, des résultats biaisés, ne reflétant plus le comportement réel des utilisateurs.

Sur quels éléments de l’interface utilisateur ?

L’évaluation sommative est toujours réalisée sur la version finale de l’interface, c’est-à-dire celle qui sera mise sur le marché. Cela comprend le dispositif (physique ou numérique), les documents d’accompagnement, la formation, le packaging et les étiquettes.

Quelles méthodes utiliser ?

Plusieurs méthodes sont acceptées, mais les tests utilisateurs sont requis par défaut. Si une autre méthode est utilisée, il faut justifier en quoi les tests utilisateurs ne sont pas applicables.

Voici la liste des méthodes acceptées :

- Tests utilisateurs (par défaut)

- Entretiens

- Revue d’experts

- Analyse de tâches

- Simulation

- PCA analysis

- Observation

- Standards review

- Advisory panel reviews

- FMEA & FTA

- Questionnaires

Avec quels utilisateurs ?

L’évaluation sommative doit être réalisé avec minimum 15 utilisateurs finaux représentatifs par groupes utilisateurs tel que définis dans la spécification d’utilisation.

Les utilisateurs doivent avoir des profils avec des caractéristiques variés (âge, sexe, expérience…) d’autant plus lorsqu’il s’agit d’un profil grand public.

Dans quel environnement ?

Les tests utilisateurs doivent être réalisés des conditions réalistes, représentatives de l’usage réel : lumière, bruit, stress, conditions stériles, distractions, etc. Ces conditions sont décrites dans la spécification d’utilisation.

Comment se déroule les tests utilisateurs ?

1. Rédiger le protocole

Le protocole est l’étape de préparation la plus importante d’une évaluation, car il en définit le cadre : objectif, méthodologie, choix des scénarios, tâches demandées aux participants, comportement attendu, etc. Il permet d’assurer que chaque test soit identique et que chaque tâche critique soit réalisée.

2. Former les utilisateurs

Si une formation au dispositif est prévue lors de la mise sur le marché, elle doit être identique ici (format, contenu, etc). Un délai est obligatoire entre la formation et le test et doit être au plus proche de la réalité.

3. Réaliser les scénarios d’utilisation

Après une courte introduction, le participant va réaliser les scénarios définis dans le protocole et donnés à l’écrit par le modérateur.

Chaque scénario regroupe un ensemble de tâches menant à un résultat attendu.

Par exemple, on souhaite que le participant injecte une dose de 4 unités. On va alors venir observer :

- Tâche 1 : L’utilisateur vérifie l’intégrité du stylo

- Tâche 2 : L’utilisateur règle la dose à 4 unités

- Tâche 3 : L’utilisateur retire le capuchon

- Tâche 4 : L’utilisateur injecte la dose.

L'objectif du modérateur ici est d’observer si des événements (erreur d’utilisation, difficulté ou presqu’erreur) se produisent.

Par exemple sur la tâche 2 :

- Erreur d’utilisation : L’utilisateur règle la dose à 8 unités sans faire exprès (absence d’unités, affichage difficile à lire) et réalise l’injection.

- Difficulté : L’utilisateur soupire, met du temps à trouver comment régler la dose mais finit par y arriver.

- Presqu’erreur : L’utilisateur a réglé une dose à 6 unités. Avant l’injection, il regarde l’indicateur et corrige son erreur.

4. Réaliser les tâches de connaissances (knowledges tasks)

Il arrive que certains comportements ne puissent être observés via des scénarios d’utilisation, par exemple la compréhension des informations, comme les contre-indications. On va alors les évaluer via des questions appelées « tâches de connaissances », également données à l’écrit par le modérateur.

5. Mener un débriefing

A la fin du test, c’est-à-dire des scénarios d’utilisation et des tâches de connaissance, le modérateur va revenir sur chaque événement avec le participant afin de comprendre comment et pourquoi celui-ci a été rencontré.

6. Questionnaire subjectif

A la fin du débriefing, le participant répond à un questionnaire subjectif permettant de recueillir sa satisfaction et ses retours concernant l’utilisation du dispositif.

7. Analyser les causes profondes

Pour chaque événement rencontré lors de l’évaluation, il est important d’identifier la cause profonde de celui-ci.

Les causes sont multiples : cela peut être liée au design de l’interface, à un artefact de l’étude (ex : une consigne mal comprise), ou encore à un transfert négatif, lorsque le participant reproduit des automatismes acquis sur un autre système qu’il utilise régulièrement.

Il est essentiel d’adopter une approche rigoureuse et nuancée dans cette analyse. Attribuer systématiquement l’origine du problème à un artefact de l’étude ou à une faute d’inattention de l’utilisateur est non seulement simpliste, mais contraire à la philosophie même de l’aptitude à l’utilisation. Si de nombreux artefacts sont observés, cela traduit souvent un protocole mal conçu : une nouvelle évaluation sommative sera alors nécessaire, la première étant biaisée.

L’objectif reste toujours de questionner la conception et le dispositif mis en place avant de remettre en cause les utilisateurs.

Comment la documenter ?

Une fois l’évaluation terminée, il est essentiel de rédiger un rapport contenant un résumé de la méthodologie, les déviations éventuelles au protocole, la présentation des participants recrutés, la synthèse des résultats par tâche, l’analyse des causes profondes pour chaque événement et la conclusion.

Vous pouvez également si vous le souhaitez, indiquer les commentaires anecdotiques (non liés à un événement) émis par les participants pendant les tests.

Et après l’évaluation sommative ?

Les résultats de l’évaluation sommative seront utilisés pour réaliser l’analyse du risque résiduel, conformément à votre procédure de gestion des risques. Cette analyse permettra de déterminer si des modifications de l’interface sont nécessaires.

Si ces modifications ont un impact sur une tâche critique ou mettent en évidence de nouveaux risques, il sera probablement indispensable de conduire une nouvelle évaluation sommative sur les parties modifiées de l’interface.

Ce type de situation délicate peut souvent être évité grâce à des évaluations formatives menées en amont. En identifiant et en corrigeant les problèmes dès les premières phases de conception, vous réduisez considérablement le risque d’avoir à modifier l’interface finale.

Conclusion